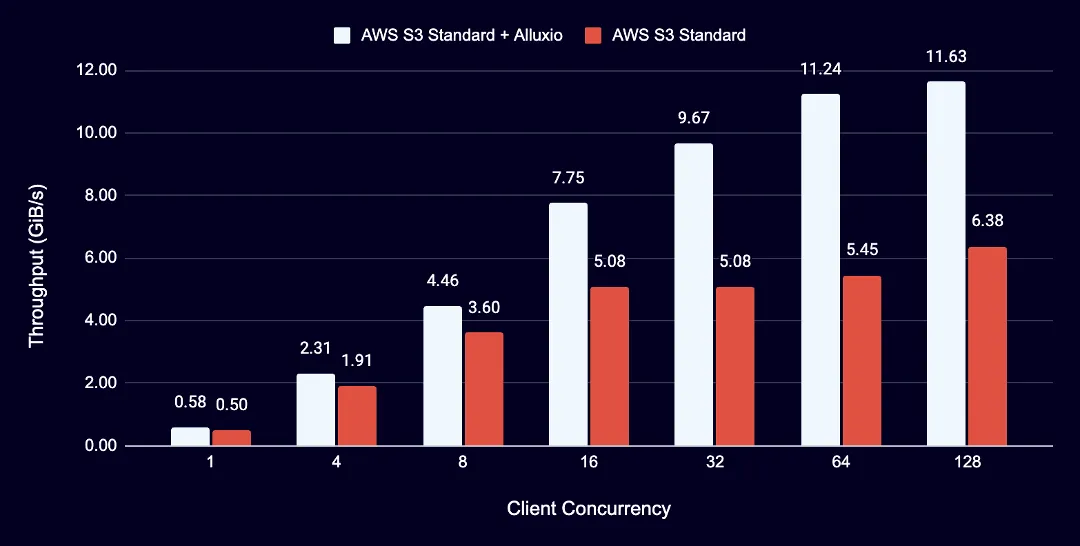

AI 应用虽受益于云存储的扩展性和成本优势,却始终受困于延迟问题。为了弥合差距,Alluxio AI 3.7 应势而生。通过面向云存储的超低延迟缓存解决方案,可将高延迟云存储转变为低延迟存储。最新版本通过透明的分布式缓存层,为云存储中 AI 数据提供亚毫秒级首字节响应(TTFB),可全面加速特征库查询、模型训练、模型部署、代理式 AI 和推理工作负载。

云存储超低延迟缓存技术解密

基于角色的S3访问控制(RBAC)

Alluxio 分布式缓存预加载器:缓存预加载速度提升 5 倍

FUSE 无中断升级

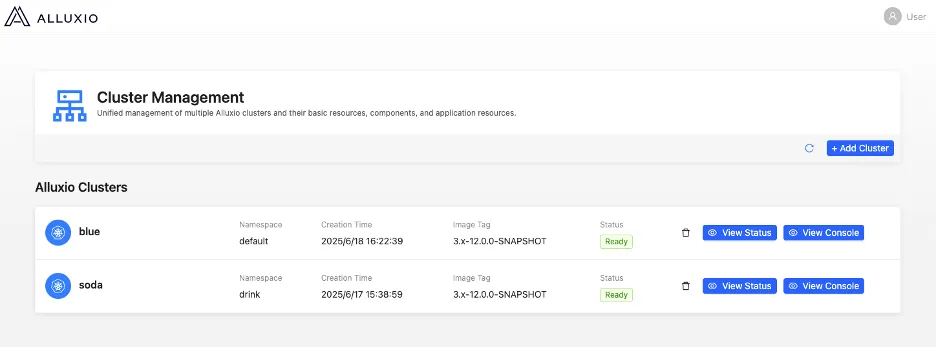

面向 Alluxio 管理员的更多新功能

使用审计日志功能审计与分析用户数据访问和操作

Alluxio 在 AI 领域一直以提供高性能数据吞吐而闻名。最新发布的 Alluxio AI 3.7 版本通过创新的”云存储超低延迟缓存”技术,在保持高吞吐优势的同时,实现了 S3 存储亚毫秒级首字节延迟(TTFB),并新增缓存预加载及安全增强功能。无论你是在训练基础模型、部署推理服务,还是构建特征库,Alluxio AI 3.7 的新功能都能确保你的 AI 工作负载高效运行。