将现有的云对象存储升级为面向 AI 的高性能存储,实现亚毫秒级延迟、Alluxio单集群达到TB/s 级吞吐与线性扩展性能——无需迁移任何数据。

为什么仅靠云对象存储不足以支撑AI?

通过Alluxio赋能云对象存储, 加速AI工作负载

客户验证:Alluxio 在 AI 场景中的真实表现

Alluxio 核心指标与性能基准

吞吐量(GiB/秒):数值越高越好

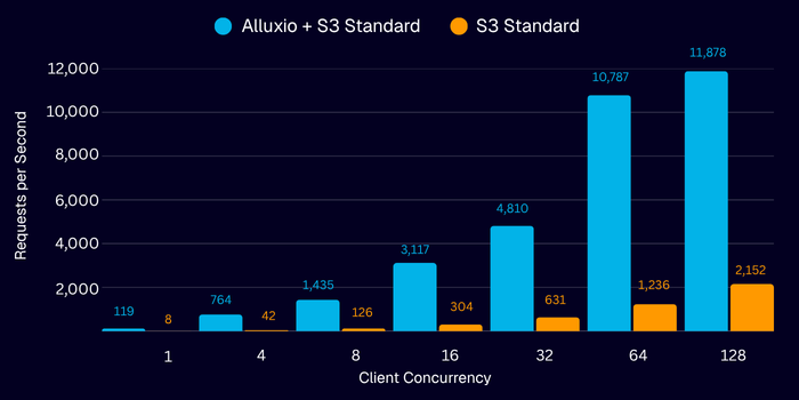

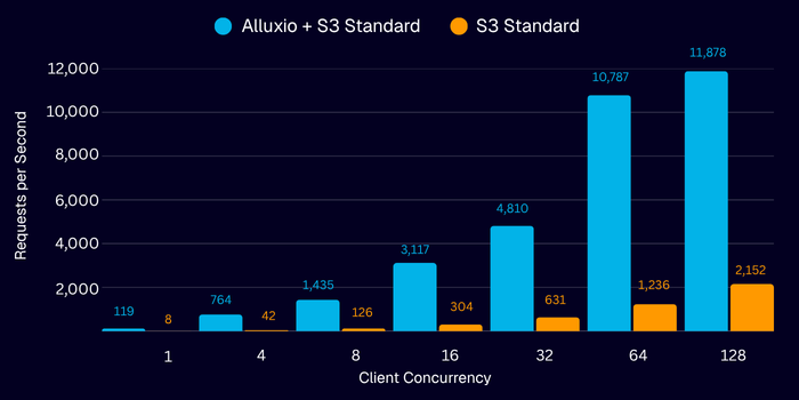

操作并发度(每秒操作次数):数值越高越好

结论

👉 叠加 Alluxio,实现极致吞吐与超低延迟的 AI 体验

将现有的云对象存储升级为面向 AI 的高性能存储,实现亚毫秒级延迟、Alluxio单集群达到TB/s 级吞吐与线性扩展性能——无需迁移任何数据。

客户验证:Alluxio 在 AI 场景中的真实表现

吞吐量(GiB/秒):数值越高越好

操作并发度(每秒操作次数):数值越高越好

结论

借助 Alluxio S3 写缓存,小对象 PUT 延迟降至约 4-6 毫秒,提升幅度达到 5-8 倍;而大对象写入在低延迟且稳定状态下,每个 Alluxio worker 可持续保持 6GB/s 以上速度,随着 Alluxio worker 的增加,性能几乎呈线性扩展。

通过引入 Alluxio,Fireworks AI 将原本依赖人工、易出错的模型服务架构,升级为自动化、高性能的现代系统。Alluxio 不仅解决了核心技术瓶颈——冷启动延迟,还在客户体验、成本控制和工程效率等多个维度创造了实际业务价值。

企业级数据访问加速平台领导者 Alluxio 宣布上线 Oracle 云市场(Oracle

京公网安备 11010802040260号

京公网安备 11010802040260号